在本文中,我们将带你了解FFmpeg-是否可以根据其SSIM值截取视频流在这篇文章中,我们将为您详细介绍FFmpeg-是否可以根据其SSIM值截取视频流的方方面面,并解答ffmpeg根据帧号截取常见的

在本文中,我们将带你了解FFmpeg - 是否可以根据其 SSIM 值截取视频流在这篇文章中,我们将为您详细介绍FFmpeg - 是否可以根据其 SSIM 值截取视频流的方方面面,并解答ffmpeg根据帧号截取常见的疑惑,同时我们还将给您一些技巧,以帮助您实现更有效的Android使用FFmpeg(三)--ffmpeg实现视频播放、asp+ffmpeg获取视频的时长、C# 视频上传之使用 ffmpeg 截取视频第一帧当做背景图、FFmpeg map参数选择音视频流。

本文目录一览:- FFmpeg - 是否可以根据其 SSIM 值截取视频流(ffmpeg根据帧号截取)

- Android使用FFmpeg(三)--ffmpeg实现视频播放

- asp+ffmpeg获取视频的时长

- C# 视频上传之使用 ffmpeg 截取视频第一帧当做背景图

- FFmpeg map参数选择音视频流

FFmpeg - 是否可以根据其 SSIM 值截取视频流(ffmpeg根据帧号截取)

如何解决FFmpeg - 是否可以根据其 SSIM 值截取视频流?

我有一个视频流,其中不时发生某个恒定事件。例如,交通灯变绿。每次事件发生时,我想剪掉几秒钟的视频(继续这个例子,汽车开始移动)。我设法使用预定义的图像和 SSIM 来检测事件(在 SSIM 日志文件中),但我找不到根据其 SSIM 值实时剪切流的方法。任何帮助将不胜感激。

解决方法

暂无找到可以解决该程序问题的有效方法,小编努力寻找整理中!

如果你已经找到好的解决方法,欢迎将解决方案带上本链接一起发送给小编。

小编邮箱:dio#foxmail.com (将#修改为@)

Android使用FFmpeg(三)--ffmpeg实现视频播放

前言

如果你已经准备好ffmpeg的开发环境,那么我们在这篇文章中实现对视频的一个播放,如果还没有准备好,请看前面的内容。

正文

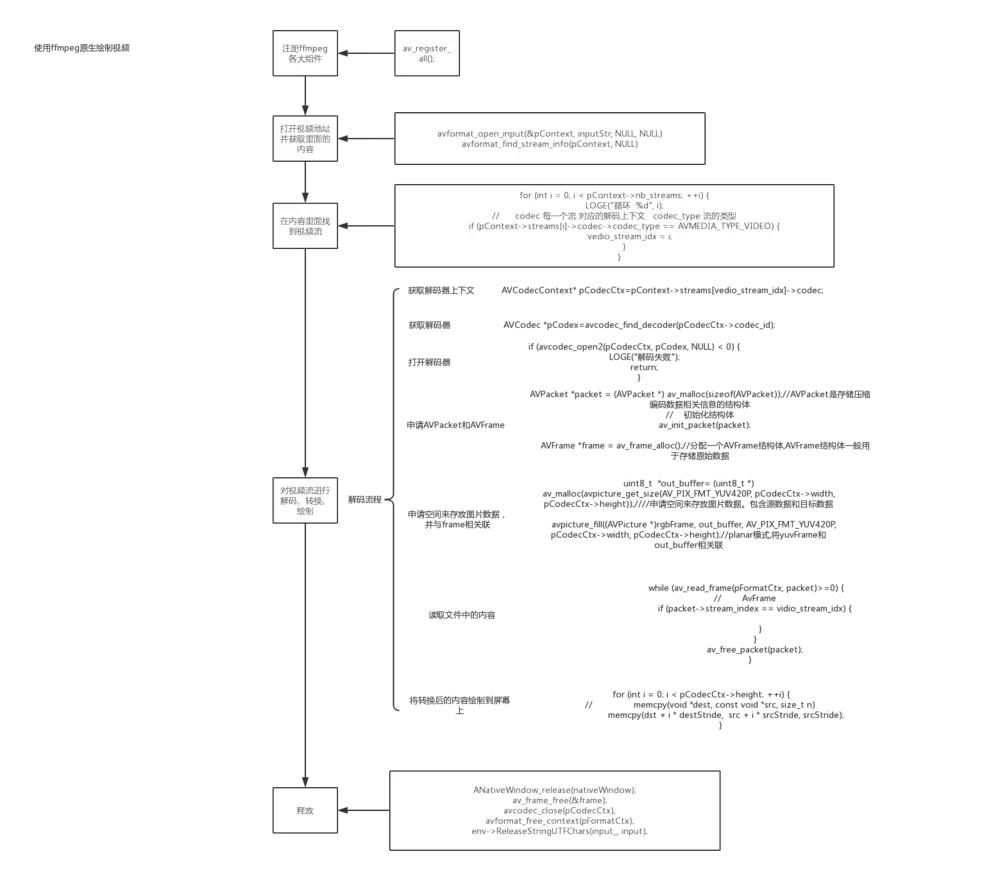

Ok,上图就是使用ffmpeg实现了一个视频的播放的大概流程图,那么,我们将根据流程图来编写代码,这样子,代码的编写就会显得比较简单,比较好理解了。

1.注册各大组件,这一步很重要,如果不注册就无法使用后面的函数了。

av_register_all();

2.在解码之前我们得获取里面的内容吧,所以这一步就是打开地址并且获取里面的内容。其中avFormatContext是内容的一个上下文,inputPath为输入的地址。

AVFormatContext *avFormatContext = avformat_alloc_context();//获取上下文

avformat_open_input(&avFormatContext, inputPath, NULL, NULL)//解封装

avformat_find_stream_info(avFormatContext, NULL)

3.我们在上面已经获取了内容,但是在一个音视频中包括了音频流,视频流和字幕流,所以在所有的内容当中,我们应当找出相对应的视频流。

int video_index=-1;

for (int i = 0; i < avFormatContext->nb_streams; ++i) {

if (avFormatContext->streams[i]->codec->codec_type == AVMEDIA_TYPE_VIDEO) {

//如果是视频流,标记一哈

video_index = i;

}

}

4.在第三步的时候已经找到了视频流,那么我们就对视频流进行解码、转换和绘制。

a.如果要进行解码,那么得有解码的装置并打开解码的装置。

//获取解码的装置上下文

AVCodecContext *avCodecContext = avFormatContext->streams[video_index]->codec;

//获取解码的装置

AVCodec *avCodec = avcodec_find_decoder(avCodecContext->codec_id);

//打开解码的装置

if (avcodec_open2(avCodecContext, avCodec, NULL) < 0) {

LOGE("打开失败")

return;

}

b.申请AVPacket和AVFrame,其中AVPacket的作用是:保存解码之前的数据和一些附加信息,如显示时间戳(pts)、解码时间戳(dts)、数据时长,所在媒体流的索引等;AVFrame的作用是:存放解码过后的数据。

具体可参考:http://blog.csdn.net/leixiaohua1020/article/details/11693997

//申请AVPacket

AVPacket *packet = (AVPacket *) av_malloc(sizeof(AVPacket));

av_init_packet(packet);

//申请AVFrame

AVFrame *frame = av_frame_alloc();//分配一个AVFrame结构体,AVFrame结构体一般用于存储原始数据,指向解码后的原始帧

AVFrame *rgb_frame = av_frame_alloc();//分配一个AVFrame结构体,指向存放转换成rgb后的帧

c.因为rgb_frame是一个缓存区域,所以需要设置。

//缓存区

uint8_t *out_buffer= (uint8_t *)av_malloc(avpicture_get_size(AV_PIX_FMT_RGBA,

avCodecContext->width,avCodecContext->height));

//与缓存区相关联,设置rgb_frame缓存区

avpicture_fill((AVPicture *)rgb_frame,out_buffer,AV_PIX_FMT_RGBA,avCodecContext->width,avCodecContext->height);

d.因为是原生绘制,即是说需要ANativeWindow。

//取到nativewindow

ANativeWindow *nativeWindow=ANativeWindow_fromSurface(env,surface);

if(nativeWindow==0){

LOGE("nativewindow取到失败")

return;

}

//视频缓冲区

ANativeWindow_Buffer native_outBuffer;

e.一切准备妥当,那么我们开始解码。

while (av_read_frame(avFormatContext, packet) >= 0) {

LOGE("解码 %d",packet->stream_index)

LOGE("VINDEX %d",video_index)

if(packet->stream_index==video_index){

LOGE("解码 hhhhh")

//如果是视频流

//解码

avcodec_decode_video2(avCodecContext, frame, &frameCount, packet)

}

av_free_packet(packet);

}

f.以下均在循环里面进行,当解码一帧成功过后,我们转换成rgb格式并且绘制。

if (frameCount) {

LOGE("转换并绘制")

//说明有内容

//绘制之前配置nativewindow

ANativeWindow_setBuffersGeometry(nativeWindow,avCodecContext->width,avCodecContext->height,WINDOW_FORMAT_RGBA_8888);

//上锁

ANativeWindow_lock(nativeWindow, &native_outBuffer, NULL);

//转换为rgb格式

sws_scale(swsContext,(const uint8_t *const *)frame->data,frame->linesize,0,

frame->height,rgb_frame->data,

rgb_frame->linesize);

// rgb_frame是有画面数据

uint8_t *dst= (uint8_t *) native_outBuffer.bits;

// 拿到一行有多少个字节 RGBA

int destStride=native_outBuffer.stride*4;

//像素数据的首地址

uint8_t * src= rgb_frame->data[0];

// 实际内存一行数量

int srcStride = rgb_frame->linesize[0];

//int i=0;

for (int i = 0; i < avCodecContext->height; ++i) {

// memcpy(void *dest, const void *src, size_t n)

//将rgb_frame中每一行的数据复制给nativewindow

memcpy(dst + i * destStride, src + i * srcStride, srcStride);

}

//解锁

ANativeWindow_unlockAndPost(nativeWindow);

usleep(1000 * 16);

}

在上面的代码中,因为转换成rgb格式过后的内容是存在ffmpeg所指向的地址而不是ANativeWindow所指向的所在地址,所以要绘制的话我们需要将内容复制到ANativeWindow中。

5.完成过后得释放资源,不然就造成内存泄露了。

ANativeWindow_release(nativeWindow);

av_frame_free(&frame);

av_frame_free(&rgb_frame);

avcodec_close(avCodecContext);

avformat_free_context(avFormatContext);

env->ReleaseStringUTFChars(inputStr_, inputPath);

6.java层代码,因为是原生绘制,所以需要传入Surface,所以创建一个类继承SurfaceView。

class VideoView : SurfaceView {

constructor(context: Context) : super(context) {}

constructor(context: Context, attrs: AttributeSet) : super(context, attrs) {

init()

}

private fun init() {

val holder = holder

holder.setFormat(PixelFormat.RGBA_8888)

}

constructor(context: Context, attrs: AttributeSet, defStyleAttr: Int) : super(context, attrs, defStyleAttr) {}

fun player(input: String) {

Thread(Runnable {

// 绘制功能 不需要交给SurfaveView VideoView.this.getHolder().getSurface()

render(input, this@VideoView.holder.surface)

}).start()

}

external fun render(input: String, surface: Surface)

companion object {

init {

System.loadLibrary("avcodec-56")

System.loadLibrary("avdevice-56")

System.loadLibrary("avfilter-5")

System.loadLibrary("avformat-56")

System.loadLibrary("avutil-54")

System.loadLibrary("postproc-53")

System.loadLibrary("swresample-1")

System.loadLibrary("swscale-3")

System.loadLibrary("native-lib")

}

}

}

小结

以上就是对视频的解封装,解码,转换,绘制的一个过程,过程清晰明了,按着这个步奏来就应该来说比较简单,另外,请在真机上测试,同时导入自己想测试的视频,什么格式都可以。

asp+ffmpeg获取视频的时长

<%

''视频数据定义

ffmpeg = "C:\ffmpeg\bin\ffmpeg.exe"

video = "D:\test\ffmpeg\test2\m1080p1.wmv"

''wscript脚本定义

set WshShell = CreateObject("Wscript.Shell")

str2 = "cmd.exe /c "&ffmpeg&" -i "&video&" 2>&1 -t Duration" ''ffmpeg 命令行 + win环境

set get_time = WshShell.Exec (str2)

n_time = get_time.StdOut.Readall

''截取字符串:视频播放时长

dstr_time=instr(n_time,"Duration") '' 用来判断是否含有某些字符串

dstr_time = dstr_time + 10

str_time=Mid(n_time,dstr_time,8)

''显示结果

Response.write ("<br/>视频文件"&video&"<br/>")

Response.write "<br/>"&"播放时长 = "&str_time

%>

C# 视频上传之使用 ffmpeg 截取视频第一帧当做背景图

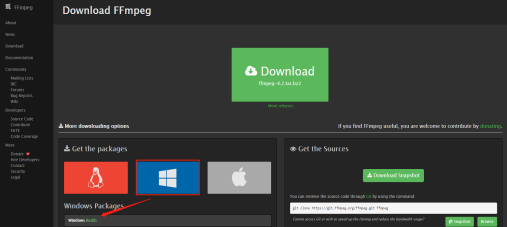

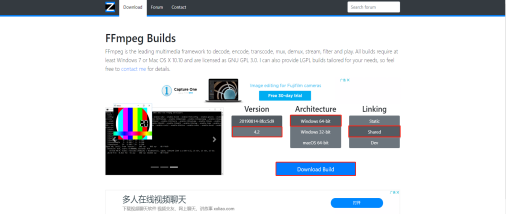

1、在官网下载 ffmpeg,http://ffmpeg.org/download.html

我下载的是 Windows 64 的,如系统是 Windows 32,请下载 Windows 32-bit

下载完成后解压,得到如下图文件:

打开 bin 文件:

把 bin 文件夹所有.dll 和.exe 文件复制到项目 bin 文件夹下。

如果想通过 cmd 命令截取,需要将 ffmpeg.exe 的路径配置到环境变量里的 Path 里 , 可参考 https://www.cnblogs.com/hbtmwangjin/articles/9519848.html 。

我这里是通过代码截取第一帧图片,保存到后台,并把图片路径保存到数据库中,没有配置环境变量也可以操作。

截取图片方法:

/// <summary>

/// 从视频画面中截取一帧画面为图片

/// </summary>

/// <param name="videoName">视频文件路径pic/123.MP4</param>

/// <param name="widthAndHeight">图片的尺寸如:240*180</param>

/// <param name="cutTimeFrame">开始截取的时间如:"1s"</param>

/// <returns>返回图片保存路径</returns>

public static string GetPicFromVideo(string videoName, string widthAndHeight, string cutTimeFrame)

{

var vdoName = videoName.Substring(videoName.LastIndexOf("/") + 1);

var fileName = vdoName.Split(''.'')[0];

var dtime = DateTime.Now.ToString("yyyy-MM-dd");

var basePath = System.Web.HttpContext.Current.Server.MapPath("~");

var ImgPath = basePath + "upload\\Images\\" + dtime;

//ffmpeg.exe路径

var ffmpeg = basePath + "bin\\ffmpeg.exe";

var srcName = basePath + videoName.Replace("/", "\\");

if (!Directory.Exists(ImgPath))

{

Directory.CreateDirectory(ImgPath);

}

//保存截取图片后路径

var objName = " "+ ImgPath + "\\"+ fileName + ".jpg";

var startInfo = new ProcessStartInfo(ffmpeg);

startInfo.WindowStyle = ProcessWindowStyle.Hidden;

startInfo.Arguments = " -i " + srcName + " -y -f image2 -ss " + cutTimeFrame + " -t 0.001 -s " + widthAndHeight + " " + objName;

//startInfo.UseShellExecute = false;

//startInfo.CreateNoWindow = true;

try

{

Process.Start(startInfo);

//返回图片保存路径

return "/upload/Images/" + dtime+"/" + fileName + ".jpg";

}

catch (Exception re)

{

//Log.WriteLog(re.Message);

return "";

}

}

调用:

var gb_img_scr = PicFromVideo.GetPicFromVideo(src, "160*300", "1");

FFmpeg map参数选择音视频流

FFmpeg命令行map参数选择音视频流

介绍

-

-map参数告诉ffmpeg要从输入源中选择/拷贝哪个stream流到输出,可以从输入源中选择多个音视频流作为输出。 - 不加

-map参数,ffmpeg默认从输入源中的视频流和音频流各选择一个流。 - 输出流/文件的stream顺序取决于在命令行中

-map的参数顺序。

默认情况

缺省情况下(没有使用-map参数),比如:

ffmpeg -i 0001.ts -c copy -f mpegts udp://192.168.1.100&pkt_size=1316FFmpeg会默认从所有输入流中找到[最高质量的一个视频输入流]和[最高质量的一个音频输入流],并拷贝流输出udp输出流。其他流实质上会被丢弃。

如果使用map命令显示与上面命令相同的操作,它的命令如下:

ffmpeg -i 0001.ts \

-map single_highest_quality_video_stream_from_all_inputs \

-map single_highest_quality_audio_stream_from_all_inputs \

-c copy -f mpegts "udp://192.168.1.100:1234?pkt_size=1316"此处输出将有两个流,一个音频,一个视频。

指定输入流中的音视频流

例子,0001.ts是个单视频流,多音频流的信息如下:

-

Stream #0:0是视频流 -

Stream #0:1~Stream #0:3是音频流 -

Stream #0:4是字幕流

Input #0, mpegts, from ''0001.ts'':

Duration: 00:04:46.23, start: 57251.747478, bitrate: 5861 kb/s

Program 34

Metadata:

service_name : Test TV HD

service_provider: TV5

Stream #0:0[0x53d]: Video: h264 (High) ([27][0][0][0] / 0x001B), yuv420p(tv, bt470bg, top first), 1920x1080 [SAR 1:1 DAR 16:9], 25 fps, 50 tbr, 90k tbn, 50 tbc

Stream #0:1[0x53e](THA): Audio: aac_latm (HE-AACv2) ([17][0][0][0] / 0x0011), 48000 Hz, stereo, fltp

Stream #0:2[0x53f](QAA): Audio: aac_latm (HE-AACv2) ([17][0][0][0] / 0x0011), 48000 Hz, stereo, fltp

Stream #0:3[0x540](NAR): Audio: aac_latm (LC) ([17][0][0][0] / 0x0011), 48000 Hz, stereo, fltp

Stream #0:4[0x541](tha): Subtitle: dvb_subtitle ([6][0][0][0] / 0x0006)01 如要要指定取多视频和多音频流中的一路流,要怎么处理呢?

如下命令:

-map 0:0 -map 0:2

选择输入源中Stream #0:0的视频流,Stream #0:2的音频流,拷贝选择的音视频流输出到udp输出流

ffmpeg -i 0001.ts -map 0:0 -map 0:2 -c copy -f mpegts "udp://192.168.1.100:1234?pkt_size=1316"02 如要要指定取单路视频流和多路音频流,要怎么处理呢?

如下命令:

-map 0:0 -map 0:1 -map 0:2 -map 0:3

选择输入源中Stream #0:0的视频流,Stream #0:0、Stream #0:1和Stream #0:3的三路音频流,拷贝选择的音视频流输出到udp输出流

ffmpeg -i 0001.ts -map 0:0 -map 0:1 -map 0:2 -map 0:3 \

-c copy -f mpegts "udp://192.168.1.100:1234?pkt_size=1316"03 如要要取所有的视频和音频流,要怎么处理呢?

如下命令:

-map 0:a -map 0:v

选择输入源中所有视频流和所有的音频,拷贝所有的音视频流输出到udp流中

ffmpeg -i 0001.ts -map 0:a -map 0:v -c copy -f mpegts "udp://192.168.1.100:1234?pkt_size=1316"04 如要要取所有流(包括字幕流等),要怎么处理呢?

如下命令:

-map 0

选择输入源中所有的流,拷贝所有的流输出到udp流中

ffmpeg -i 0001.ts -map 0 -c copy -f mpegts "udp://192.168.1.100:1234?pkt_size=1316"指定输入流中的多音视频流编码格式

有时处理输入源中的多视频和多音频流时,想针对不同音视频流做不同的编码处理

如下命令:

- 将

Stream #0:0视频流拷贝复制 - 将

Stream #0:1和Stream #0:2音频流拷贝复制 - 将

Stream #0:2音频流编码为mp3格式(128kbps) - 将

Stream #0:4字幕流拷贝复制

fffmpeg -i 0001.ts -map 0:0 -map 0:1 -map 0:2 -map 0:3 -map 0:4 \

- c:v copy \

- c:a:0 copy \

- c:a:1 copy \

- c:a:2 libmp3lame -b:a:2 128k \

- c:s copy \

-f mpegts "udp://192.168.1.100:1234?pkt_size=1316"我们今天的关于FFmpeg - 是否可以根据其 SSIM 值截取视频流和ffmpeg根据帧号截取的分享已经告一段落,感谢您的关注,如果您想了解更多关于Android使用FFmpeg(三)--ffmpeg实现视频播放、asp+ffmpeg获取视频的时长、C# 视频上传之使用 ffmpeg 截取视频第一帧当做背景图、FFmpeg map参数选择音视频流的相关信息,请在本站查询。

本文标签:

![[转帖]Ubuntu 安装 Wine方法(ubuntu如何安装wine)](https://www.gvkun.com/zb_users/cache/thumbs/4c83df0e2303284d68480d1b1378581d-180-120-1.jpg)