如果您想了解Elasticsearch6.2/Kibana查询:必须存在一个字段而不得存在一个字段和查询必须至少包含一个目标字段的知识,那么本篇文章将是您的不二之选。我们将深入剖析Elasticsea

如果您想了解Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段和查询必须至少包含一个目标字段的知识,那么本篇文章将是您的不二之选。我们将深入剖析Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段的各个方面,并为您解答查询必须至少包含一个目标字段的疑在这篇文章中,我们将为您介绍Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段的相关知识,同时也会详细的解释查询必须至少包含一个目标字段的运用方法,并给出实际的案例分析,希望能帮助到您!

本文目录一览:- Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段(查询必须至少包含一个目标字段)

- Elasticsearch --- 01 java , elasticsearch, kibana 的下载安装,es初识

- ElasticSearch 5 学习 (1)—— 安装 Elasticsearch、Kibana 和 X-Pack

- Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana

- elasticsearch kibana简单查询

Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段(查询必须至少包含一个目标字段)

我的愿望是搜索存在field_a而不存在fields_b的文档。有没有一种方法可以使用Kibana中的Lucene查询语法(Kibana的Discover部分中的Search字段)进行此操作。

我尝试使用 __missing_:field_b_ 失败( __exists_可行_ )。

我发现了这一点,但并没有太大帮助:

GET /_search{ "query": { "bool": { "must_not": { "exists": { "field": "user" } } } }}答案1

小编典典对于lucene搜索语法:

_exists_:field_a AND !_exists_:field_b

对于elasticsearch搜索语法:

{ "query" : { "bool" : { "must" : [ {"exists" : { "field" : "field_a" }} ], "must_not": [ {"exists" : { "field" : "field_b" }} ] } }}

Elasticsearch --- 01 java , elasticsearch, kibana 的下载安装,es初识

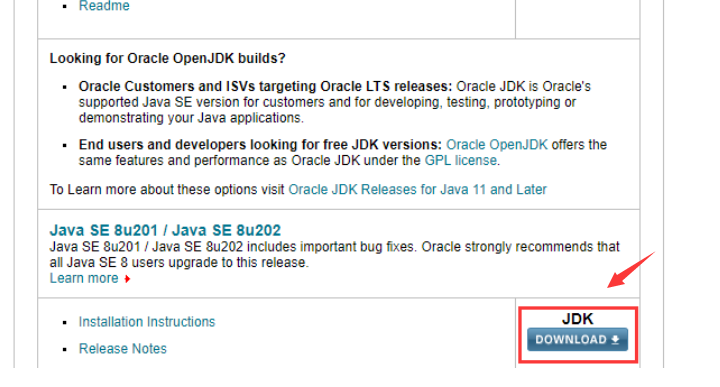

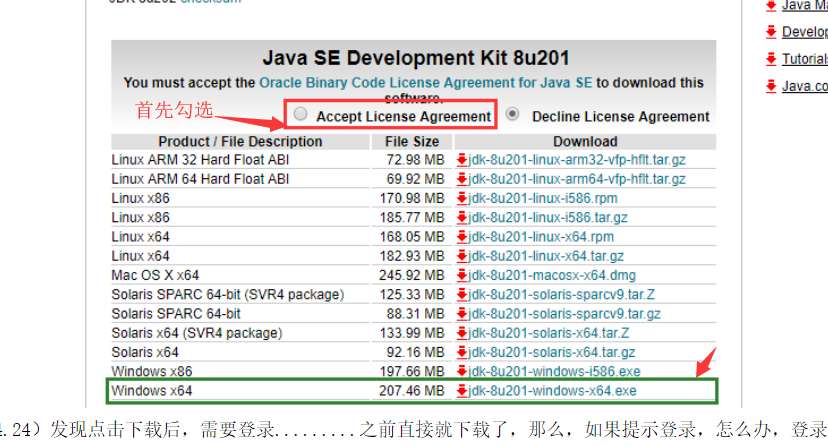

一java 的安装下载

1.下载

官网地址

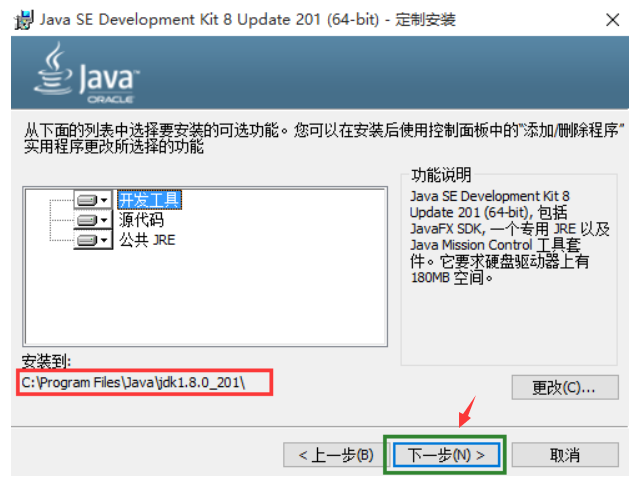

2.安装(进行默认安装,都选下一步)

3.配置环境变量

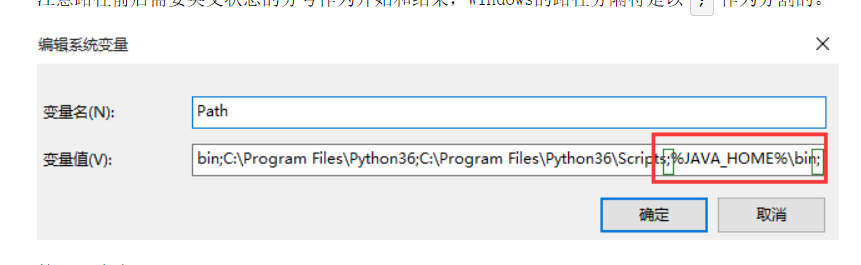

4.添加path (可不加)

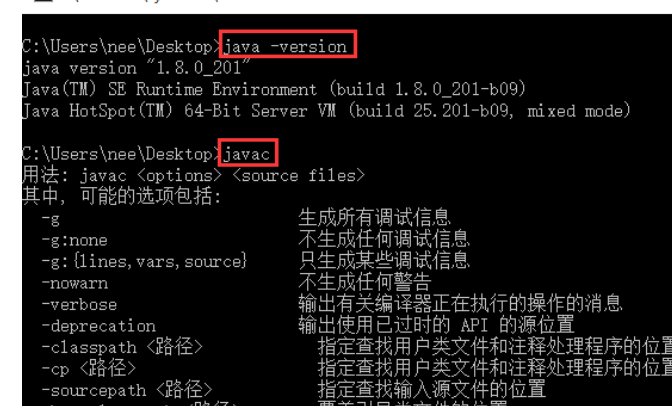

5.测试

二. elasticsearch 的安装下载

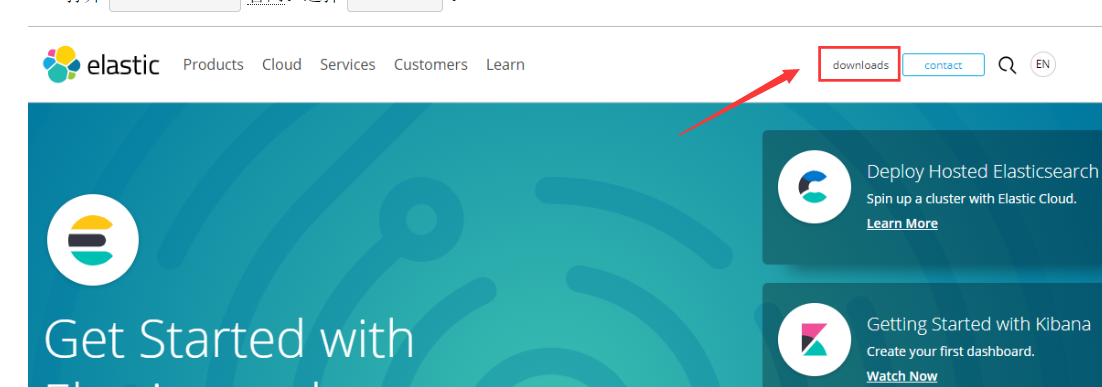

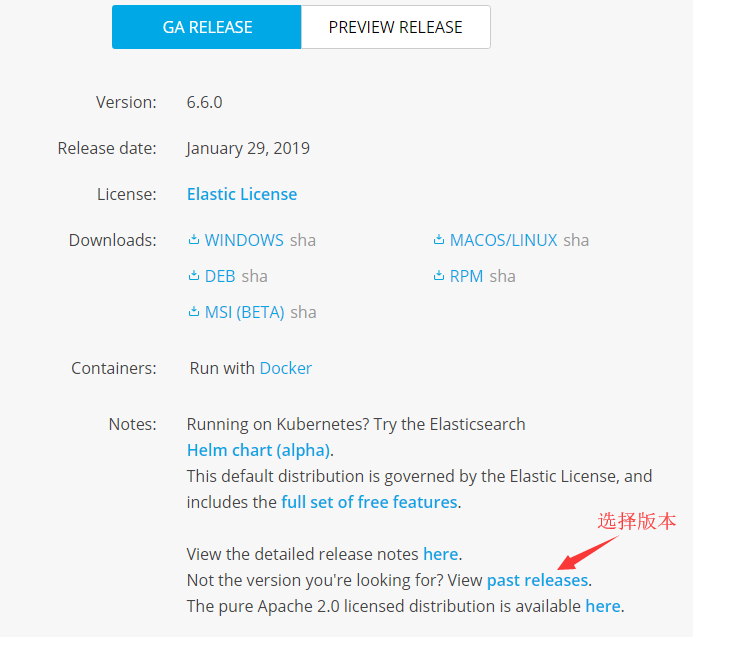

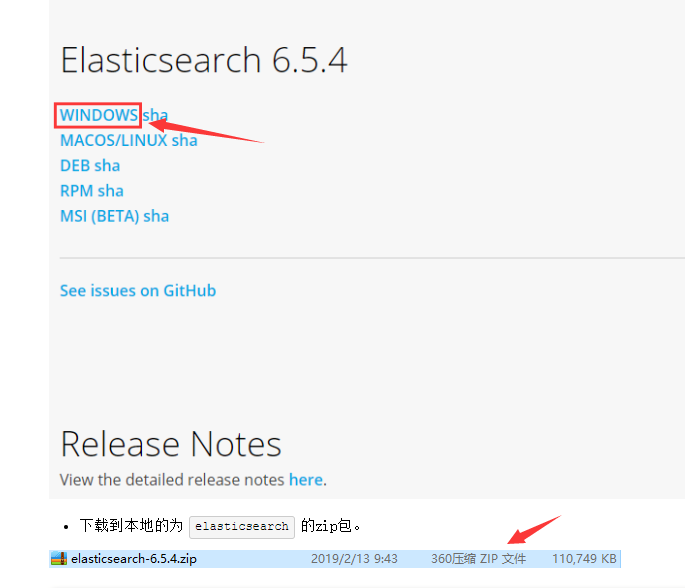

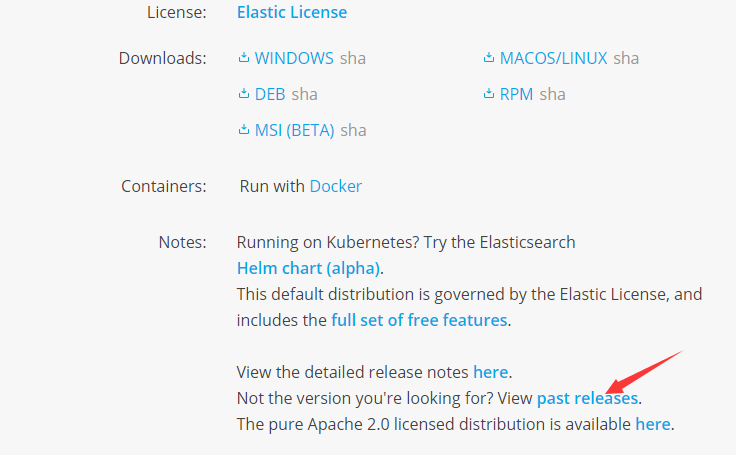

1. 下载

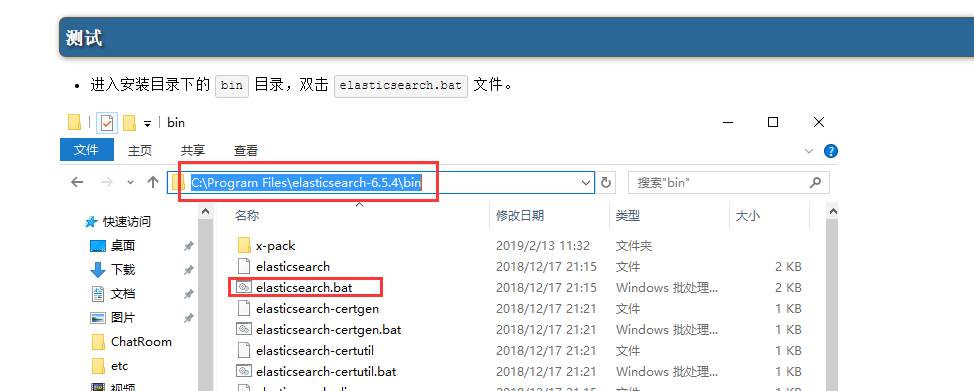

2.安装,启动

3.测试

4.可能出现的问题

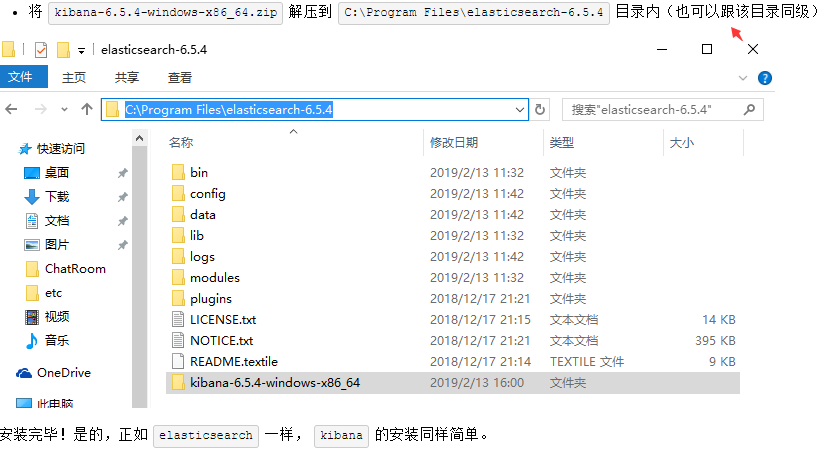

三. kibana 安装,下载

1.下载

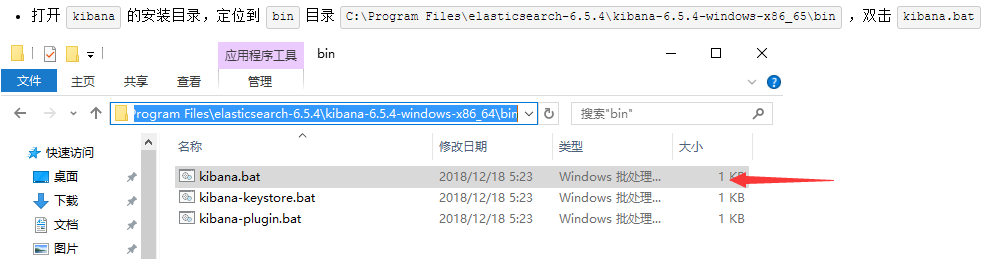

2.安装,启动

3.测试

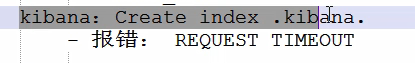

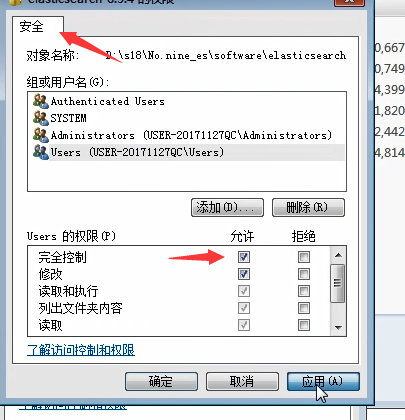

4.可能出现的问题

四.es初识

1.基本概念

文档的特性:自我包含,层次型、结构灵活、无模式

类型:在es6.x版本开始,一个索引下面只能有一个类型,类型是是文档的容器,

并且,类型记录了字段和值的映射关系。

索引: 索引是映射类型的容器,elasticsearch中的索引是一个非常大的文档集合。

索引存储了映射类型的字段和其他设置。然后它们被存储到了各个分片上了。

物理:节点,分片

节点: 一个集群至少有一个节点,节点内可以有多个索引。在创建索引时,

默认创建5个主分片,每个主分片搭配一个复制分片。

分片:文档存储在各个分片上,一个分片也是一个Lucene索引。

倒排索引: 倒排索引是一个包含不重复词条的文档,我们称该文档为倒排文档。

es的索引和Lucene的索引对比:

es的索引是由多个分片组成,而每个分片则是一个Lucene索引。

一个Lucene索引能存储不超过21亿篇文档,或者不超过2740亿个唯一词条。

2.基本操作

①添加或更新

不存在先创建,存在则添加(或更新)文档。

PUT s18/doc/1

{

"name":"大刀"

}

PUT s18/doc/2

{

"name":"鹏程"

}

PUT s18/doc/3

{

"name":"laowang"

}

②查询

GET s18/doc/1 # 查看指定文档

GET s18/doc/_search # 查看所有文档

GET s18/doc/_search?q=name:laowang # 按条件查询

GET s18/_mapping # 查看索引的映射类型

GET s18/_settings # 查看索引的设置信息

GET s18 # 查看索引的详情

③删除

DELETE s18/doc/1 # 删除指定文档

DELETE s18 # 删除索引

ElasticSearch 5 学习 (1)—— 安装 Elasticsearch、Kibana 和 X-Pack

安装准备:

安装 Elasticsearch 唯一的要求是安装官方新版的 Java,包括对应的 Jdk。

安装 Elasticsearch

首先到官网下载最新版本的 Elasticsearch 压缩包。

可以使用命令,注意将最新的可用的下载链接填入:

curl -L -O https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.0.2.zip

unzip elasticsearch-5.0.2.zip

cd elasticsearch-5.0.2运行 Elasticsearch

Elasticsearch 已经准备就绪,执行以下命令可在前台启动:

./bin/elasticsearch如果想在后台以守护进程模式运行,添加 - d 参数。

打开另一个终端进行测试:

curl ''http://localhost:9200/?pretty''你能看到以下返回信息:

{

"name": "vP19PMO",

"cluster_name": "elasticsearch",

"cluster_uuid": "IMKMfkMsSrKODIYg5gxgeQ",

"version": {

"number": "5.0.2",

"build_hash": "f6b4951",

"build_date": "2016-11-24T10:07:18.101Z",

"build_snapshot": false,

"lucene_version": "6.2.1"

},

"tagline": "You Know, for Search"

}这说明你的 ELasticsearch 集群已经启动并且正常运行。

安装 Kiabna

Kibana 是一个为 ElasticSearch 提供的数据分析的 Web 接口。可使用它对日志进行高效的搜索、可视化、分析等各种操作。

首先到官网下载最新版本的 Kiabna 压缩包。

可以使用如下命令,注意将最新的可用的下载链接填入:

wget https://artifacts.elastic.co/downloads/kibana/kibana-5.1.1-linux-x86_64.tar.gz

sha1sum kibana-5.1.1-linux-x86_64.tar.gz

tar -xzf kibana-5.1.1-linux-x86_64.tar.gz

cd kibana/注意:

- https://www.elastic.co/downloads/kibana 可以在该地址获取下载链接,一定要选择对于系统和版本。

- 按照文档的要求,一般情况下 kibana 的版本必须和 Elasticsearch 安装的版本一致。

安装 X-Pack

X-Pack 是一个 Elastic Stack 的扩展,将安全,警报,监视,报告和图形功能包含在一个易于安装的软件包中。在 Elasticsearch 5.0.0 之前,您必须安装单独的 Shield,Watcher 和 Marvel 插件才能获得在 X-Pack 中所有的功能。

下载前提

Elasticsearch 5.0.2

Kibana 5.0.2

Elasticsearch 下载 X-Pack

在 Es 的根目录(每个节点),运行 bin/elasticsearch-plugin 进行安装。

bin/elasticsearch-plugin install x-pack

安装过程中跳出选项现在 y 即可。

如果你在 Elasticsearch 已禁用自动索引的创建,在 elasticsearch.yml 配置 action.auto_create_index 允许 X-pack 创造以下指标:

action.auto_create_index: .security,.monitoring*,.watches,.triggered_watches,.watcher-history*运行 Elasticsearch。

bin/elasticsearchKibana 下载 X-Pack

在 Kibana 根目录运行 bin/kibana-plugin 进行安装。

bin/kibana-plugin install x-pack

安装过程会比较久,耐心等待。

运行 Kibana。

bin/kibana验证 X-Pack

在浏览器上输入: http://localhost:5601/ ,可以打开 Kibana,此时需要输入用户名和密码登录,默认分别是 elastic 和 changeme。

安装参考:

- 每个操作系统安装 Elasticsearch 的文件选择不同,参考:https://www.elastic.co/downloads/elasticsearch,选择对应的文件下载。

- 安装 Kiabna 需要根据操作系统做选择,参考:https://www.elastic.co/guide/en/kibana/current/install.html,选择对应的文件下载。

- 安装 X-Pack 需要根据 Elasticsearch 安装不同的方式提供不同的安装方法,参考:https://www.elastic.co/guide/en/x-pack/5.0/installing-xpack.html#installing-xpack。

名词解释

在刚接触 Elasticsearch 的时候,会有很多名词不能理解,或者不知道其中的关系。其中很多是为不同版本的 Elasticsearch 而存在的。

Marvel

Marvel 插件:在簇中从每个节点汇集数据。这个插件必须每个节点都得安装。

Marvel 是 Elasticsearch 的管理和监控工具,在开发环境下免费使用。它包含了 Sense。

Sense

交互式控制台,使用户方便的通过浏览器直接与 Elasticsearch 进行交互。

Hand

在学习 Elasticsearch 的过程中,必不可少需要通过一些工具查看 es 的运行状态以及数据。如果都是通过 rest 请求,未免太过麻烦,而且也不够人性化。此时,Head 插件可以实现基本信息的查看,rest 请求的模拟,数据的检索等等。

X-pack

x-pack 是 elasticsearch 的一个扩展包,将安全,警告,监视,图形和报告功能捆绑在一个易于安装的软件包中,也是官方推荐的。

Kibana

kibana 是一个与 elasticsearch 一起工作的开源的分析和可视化的平台。使用 kibana 可以查询、查看并与存储在 elasticsearch 索引的数据进行交互操作。使用 kibana 能执行高级的数据分析,并能以图表、表格和地图的形式查看数据。

kibana 使得理解大容量的数据变得非常容易。它非常简单,基于浏览器的接口使我们能够快速的创建和分享显示 elasticsearch 查询结果实时变化的仪表盘。

在 Elasticsearch 5 版本之前,一般都是通过安装 Kibana,而后将 Marvel、Hand 等各种功能插件添加到 Kibana 上使用。在 Elasticsearch 5 版本之后,一般情况下只需要安装一个官方推荐的 X-pack 扩展包即可。

Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana

CentOS6.5下安装ElasticSearch6.2.4

(1)配置JDK环境

配置环境变量

export JAVA_HOME="/opt/jdk1.8.0_144"

export PATH="$JAVA_HOME/bin:$PATH"

export CLASSPATH=".:$JAVA_HOME/lib"

(2)安装ElasticSearch6.2.4

下载地址:https://www.elastic.co/cn/downloads/past-releases/elasticsearch-6-2-4

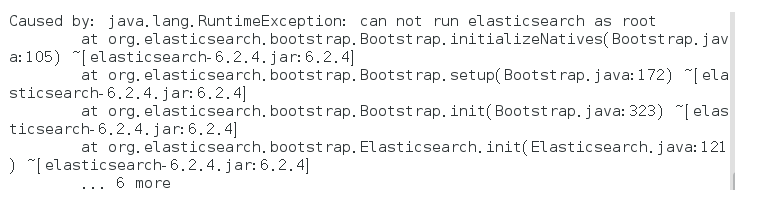

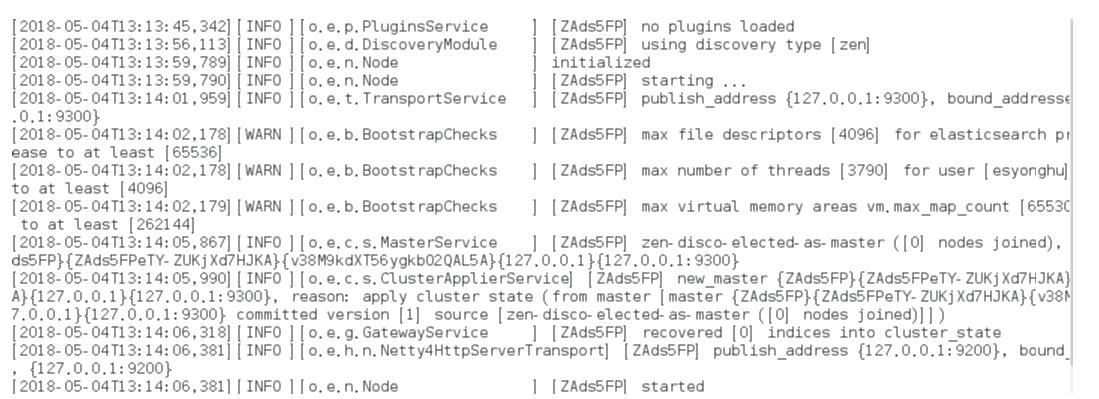

启动报错:

解决方式:

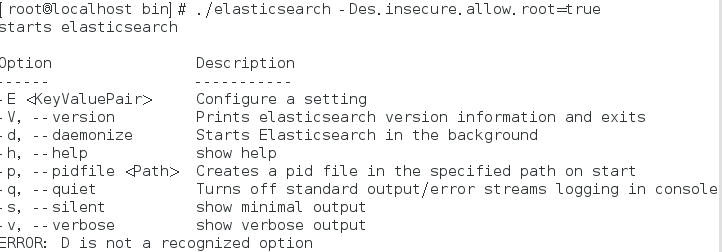

bin/elasticsearch -Des.insecure.allow.root=true

或者修改bin/elasticsearch,加上ES_JAVA_OPTS属性:

ES_JAVA_OPTS="-Des.insecure.allow.root=true"

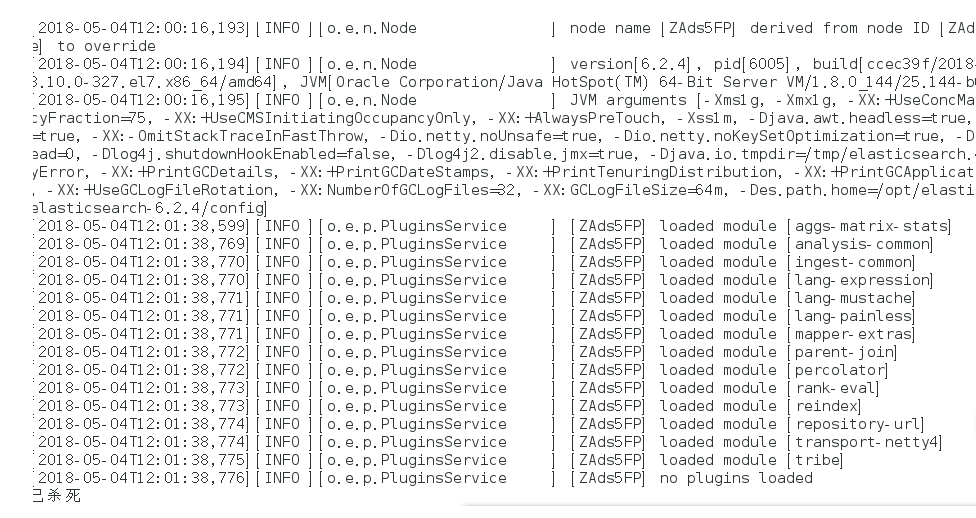

再次启动:

这是出于系统安全考虑设置的条件。由于ElasticSearch可以接收用户输入的脚本并且执行,为了系统安全考 虑,建议创建一个单独的用户用来运行ElasticSearch。

如果没有普通用户就要创建一个普通用户组和普通用户,下面介绍一下怎么创建用户组和普通用户

创建用户组和用户:

groupadd esgroup

useradd esuser -g esgroup -p espassword

更改elasticsearch文件夹及内部文件的所属用户及组:

cd /opt

chown -R esuser:esgroup elasticsearch-6.2.4

切换用户并运行:

su esuser

./bin/elasticsearch

再次启动显示已杀死:

需要调整JVM的内存大小:

vi bin/elasticsearch

ES_JAVA_OPTS="-Xms512m -Xmx512m"

再次启动:启动成功

如果显示如下类似信息:

[INFO ][o.e.c.r.a.DiskThresholdMonitor] [ZAds5FP] low disk watermark [85%] exceeded on [ZAds5FPeTY-ZUKjXd7HJKA][ZAds5FP][/opt/elasticsearch-6.2.4/data/nodes/0] free: 1.2gb[14.2%], replicas will not be assigned to this node

需要清理磁盘空间。

后台运行:./bin/elasticsearch -d

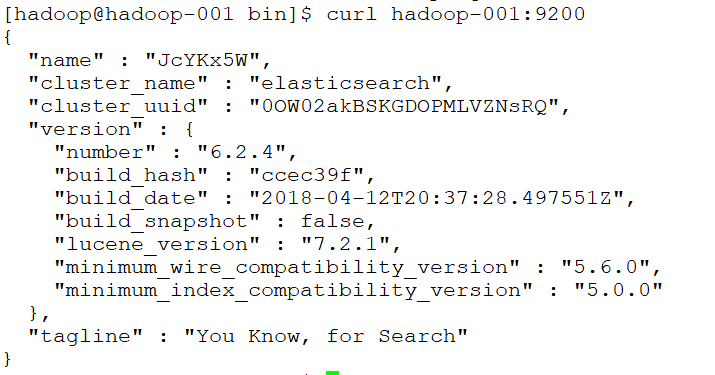

测试连接:curl 127.0.0.1:9200

会看到一下JSON数据:

[root@localhost ~]# curl 127.0.0.1:9200

{

"name" : "rBrMTNx",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "-noR5DxFRsyvAFvAzxl07g",

"version" : {

"number" : "5.1.1",

"build_hash" : "5395e21",

"build_date" : "2016-12-06T12:36:15.409Z",

"build_snapshot" : false,

"lucene_version" : "6.3.0"

},

"tagline" : "You Know, for Search"

}

实现远程访问:

需要对config/elasticsearch.yml进行 配置:

network.host: hadoop-001

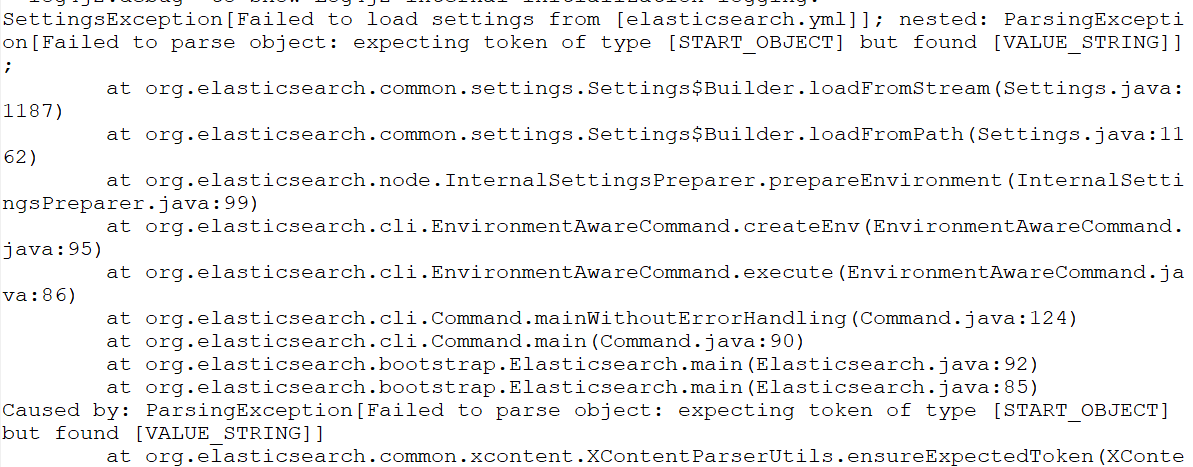

再次启动报错:Failed to load settings from [elasticsearch.yml]

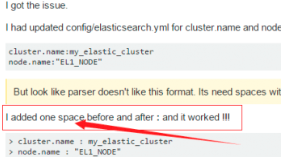

这个错就是参数的冒号前后没有加空格,加了之后就好,我找了好久这个问题;

后来在一个外国网站找到了这句话.

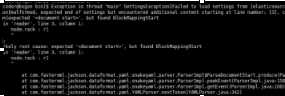

Exception in thread "main" SettingsException[Failed to load settings from [elasticsearch.yml]]; nested: ElasticsearchParseException[malformed, expected end of settings but encountered additional content starting at line number: [3], column number: [1]]; nested: ParserException[expected ''<document start>'', but found BlockMappingStart

in ''reader'', line 3, column 1:

node.rack : r1

^

];

Likely root cause: expected ''<document start>'', but found BlockMappingStart

in ''reader'', line 3, column 1:

node.rack : r1

这个是行的开头没有加空格,fuck!

Exception in thread "main" SettingsException[Failed to load settings from [elasticsearch.yml]]; nested: ScannerException[while scanning a simple key

in ''reader'', line 11, column 2:

discovery.zen.ping.unicast.hosts ...

^

参数冒号后加空格,或者是数组中间加空格

例如:

# discovery.zen.minimum_master_nodes: 3

再次启动

还是报错

max file descriptors [4096] for elasticsearch process is too low

处理第一个错误:

vim /etc/security/limits.conf //文件最后加入

esuser soft nofile 65536

esuser hard nofile 65536

esuser soft nproc 4096

esuser hard nproc 4096

处理第二个错误:

进入limits.d目录下修改配置文件。

vim /etc/security/limits.d/20-nproc.conf

修改为 esuser soft nproc 4096

注意重新登录生效!!!!!!!!

处理第三个错误:

vim /etc/sysctl.conf

vm.max_map_count=655360

执行以下命令生效:

sysctl -p

关闭防火墙:systemctl stop firewalld.service

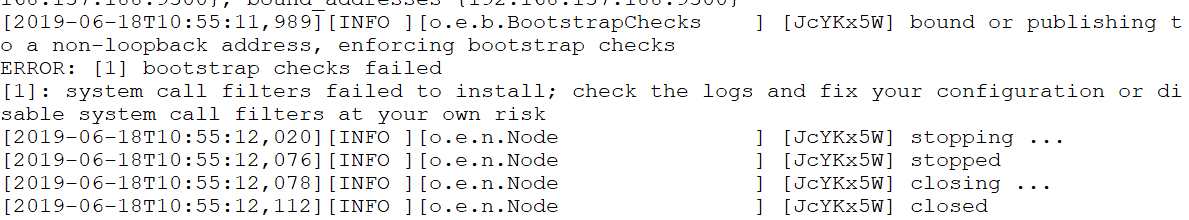

启动又又又报错

system call filters failed to install; check the logs and fix your configuration or disable sys

直接在

config/elasticsearch.yml 末尾加上一句

bootstrap.system_call_filter: false再次启动成功!

安装Head插件

Head是elasticsearch的集群管理工具,可以用于数据的浏览和查询

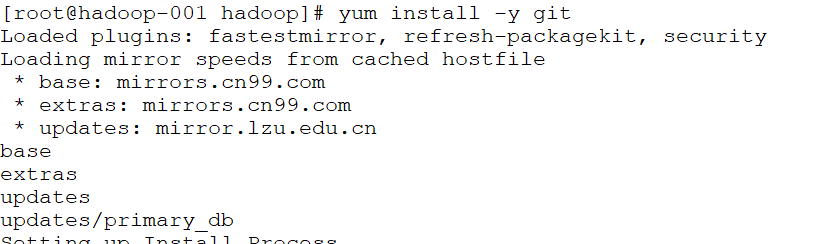

(1)elasticsearch-head是一款开源软件,被托管在github上面,所以如果我们要使用它,必须先安装git,通过git获取elasticsearch-head

(2)运行elasticsearch-head会用到grunt,而grunt需要npm包管理器,所以nodejs是必须要安装的

nodejs和npm安装:

http://blog.java1234.com/blog/articles/354.html

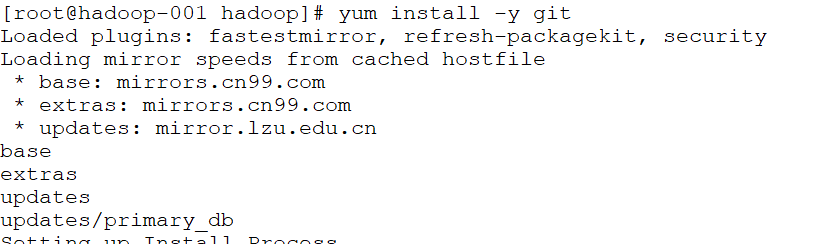

git安装

yum install -y git

(3)elasticsearch5.0之后,elasticsearch-head不做为插件放在其plugins目录下了。

使用git拷贝elasticsearch-head到本地

cd ~

git clone git://github.com/mobz/elasticsearch-head.git

(4)安装elasticsearch-head依赖包

[root@localhost local]# npm install -g grunt-cli

[root@localhost _site]# cd /usr/local/elasticsearch-head/

[root@localhost elasticsearch-head]# cnpm install

(5)修改Gruntfile.js

[root@localhost _site]# cd /usr/local/elasticsearch-head/

[root@localhost elasticsearch-head]# vi Gruntfile.js

在connect-->server-->options下面添加:hostname:’*’,允许所有IP可以访问

(6)修改elasticsearch-head默认连接地址

[root@localhost elasticsearch-head]# cd /usr/local/elasticsearch-head/_site/

[root@localhost _site]# vi app.js

将this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://localhost:9200";中的localhost修改成你es的服务器地址

(7)配置elasticsearch允许跨域访问

打开elasticsearch的配置文件elasticsearch.yml,在文件末尾追加下面两行代码即可:

http.cors.enabled: true

http.cors.allow-origin: "*"

(8)打开9100端口

[root@localhost elasticsearch-head]# firewall-cmd --zone=public --add-port=9100/tcp --permanent

重启防火墙

[root@localhost elasticsearch-head]# firewall-cmd --reload

(9)启动elasticsearch

(10)启动elasticsearch-head

[root@localhost _site]# cd ~/elasticsearch-head/

[root@localhost elasticsearch-head]# node_modules/grunt/bin/grunt server 或者 npm run start

(11)访问elasticsearch-head

关闭防火墙:systemctl stop firewalld.service

浏览器输入网址:hadoop-001:9100/

安装Kibana

Kibana是一个针对Elasticsearch的开源分析及可视化平台,使用Kibana可以查询、查看并与存储在ES索引的数据进行交互操作,使用Kibana能执行高级的数据分析,并能以图表、表格和地图的形式查看数据

(1)下载Kibana

https://www.elastic.co/downloads/kibana

(2)把下载好的压缩包拷贝到/soft目录下

(3)解压缩,并把解压后的目录移动到/user/local/kibana

(4)编辑kibana配置文件

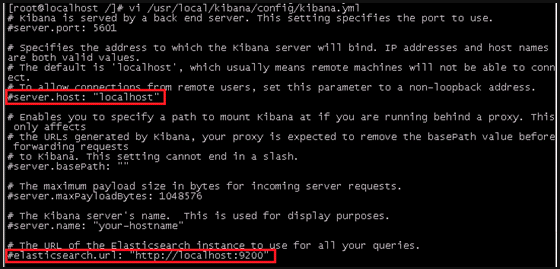

[root@localhost /]# vi /usr/local/kibana/config/kibana.yml

将server.host,elasticsearch.url修改成所在服务器的ip地址

server.port: 5601 //监听端口

server.host: "hadoo-001" //监听IP地址,建议内网ip

elasticsearch.url: "http:/hadoo-001" //elasticsearch连接kibana的URL,也可以填写192.168.137.188,因为它们是一个集群

(5)开启5601端口

Kibana的默认端口是5601

开启防火墙:systemctl start firewalld.service

开启5601端口:firewall-cmd --permanent --zone=public --add-port=5601/tcp

重启防火墙:firewall-cmd –reload

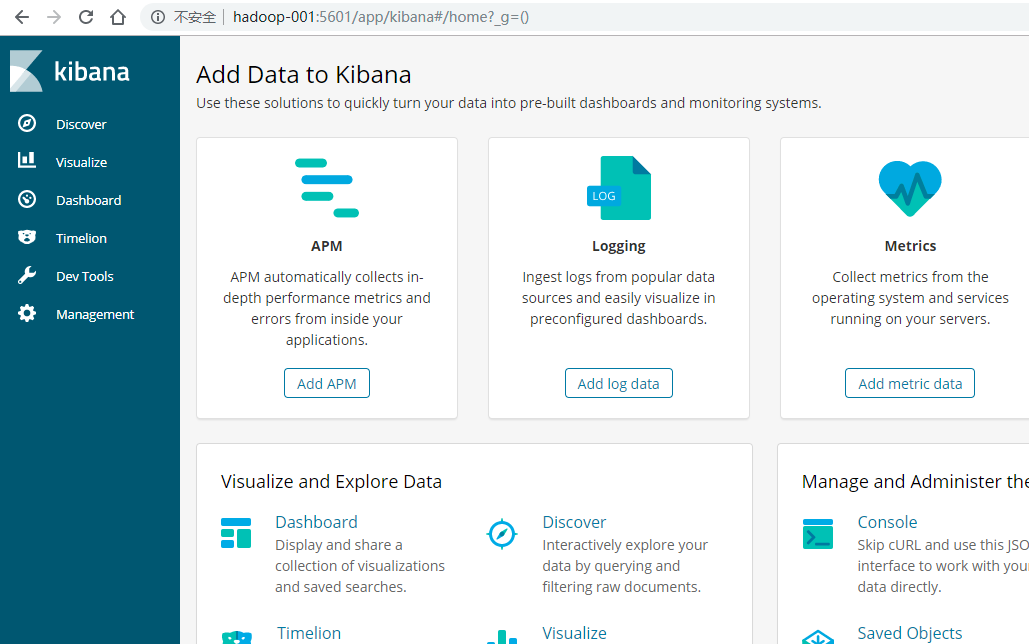

(6)启动Kibana

[root@localhost /]# /usr/local/kibana/bin/kibana

浏览器访问:http://192.168.137.188:5601

安装中文分词器

一.离线安装

(1)下载中文分词器

https://github.com/medcl/elasticsearch-analysis-ik

下载elasticsearch-analysis-ik-master.zip

(2)解压elasticsearch-analysis-ik-master.zip

unzip elasticsearch-analysis-ik-master.zip

(3)进入elasticsearch-analysis-ik-master,编译源码

mvn clean install -Dmaven.test.skip=true

(4)在es的plugins文件夹下创建目录ik

(5)将编译后生成的elasticsearch-analysis-ik-版本.zip移动到ik下,并解压

(6)解压后的内容移动到ik目录下

二.在线安装

./elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.2.4/elasticsearch-analysis-ik-6.2.4.zip

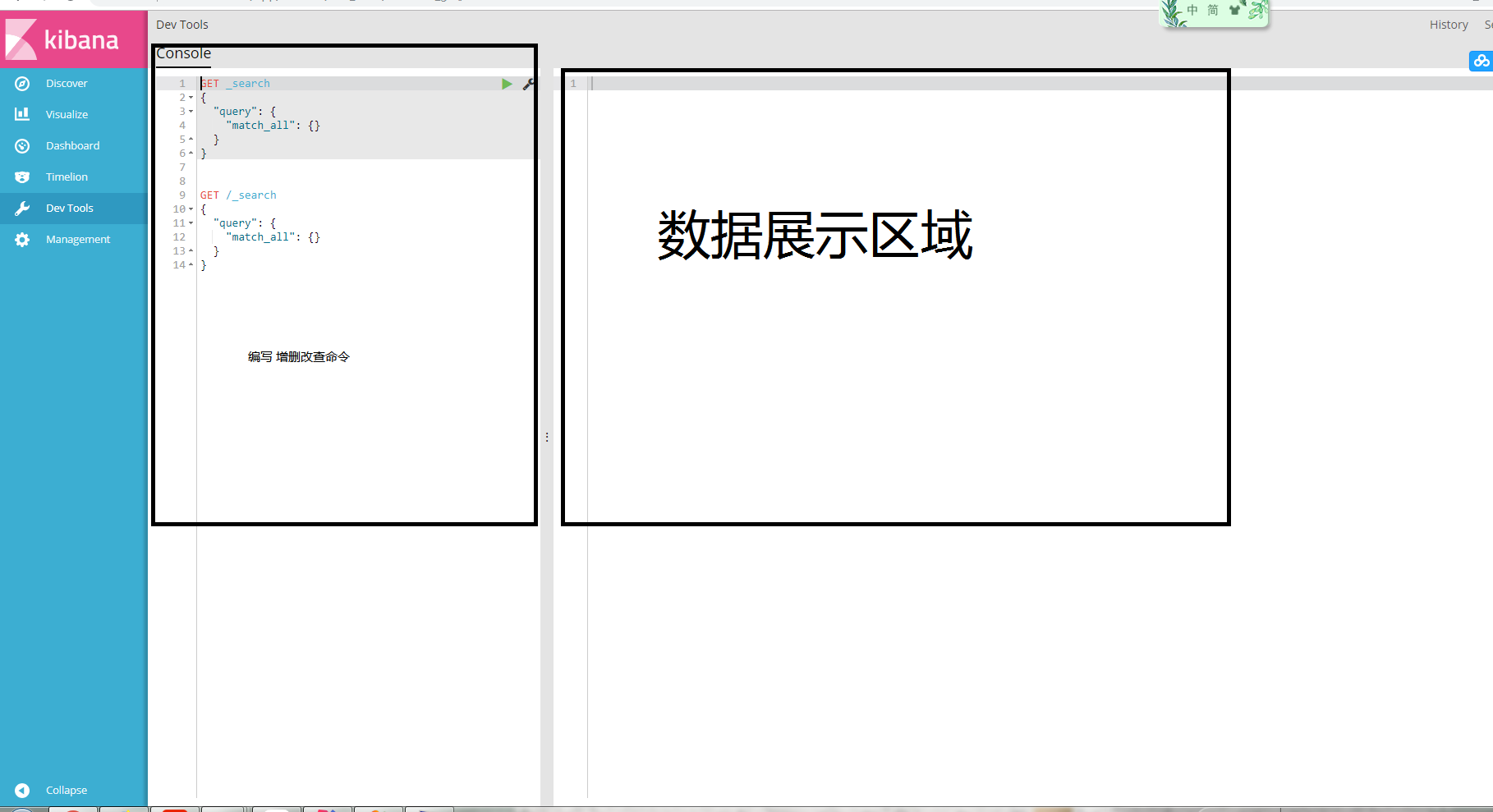

elasticsearch kibana简单查询

kibana CRUD 操作页面

一、简单的CRUD操作

1、添加

PUT /index/type/id

{

"json数据"

}

2、查询

GET /index/type/id

3、修改

POST /index/type/id/_update

{

"doc": {

"FIELD": "值"

}

}

4、删除

DELETE /index/type/id

二、搜索 搜索可以分成六大类

1、query string search

2、query DSL

3、query filter

4、full-text search

5、phrase search

6、highlight search

1)query string search

搜索全部:GET supplier/user/_search

{

"took": 2,

"timed_out": false,

"_shards": {

"total": 5,

"successful": 5,

"failed": 0

},

"hits": {

"total": 3,

"max_score": 1,

"hits": [

{

"_index": "supplier",

"_type": "user",

"_id": "2",

"_score": 1,

"_source": {

"name": "lisi",

"age": 26,

"address": "bei jing tong zhou",

"price": 10000,

"dept": [

"kaifabu"

]

}

},

{

"_index": "supplier",

"_type": "user",

"_id": "1",

"_score": 1,

"_source": {

"name": "zhangsan",

"age": 30,

"address": "bei jing chang chun jie",

"price": 15000,

"dept": [

"kaifabu",

"yanfabu"

]

}

},

{

"_index": "supplier",

"_type": "user",

"_id": "3",

"_score": 1,

"_source": {

"name": "wangwu",

"age": 26,

"address": "bei jing tong zhou yun he ming zhu",

"price": 13000,

"dept": [

"kaifabu"

]

}

}

]

}

}

took:耗费了几毫秒

timed_out:是否超时,这里是没有

_shards:数据拆成了5个分片,所以对于搜索请求,会打到所有的primary shard(或者是它的某个replica shard也可以)

hits.total:查询结果的数量,3个document

hits.max_score:score的含义,就是document对于一个search的相关度的匹配分数,越相关,就越匹配,分数也高

hits.hits:包含了匹配搜索的document的详细数据

2、query DSL

查询所有

GET supplier/user/_search

{

"query": { "match_all": {} }

}

查询全部并且排序

GET suppluer/user/_search

{

"query": {

"match_all": {}

}

, "sort": [

{

"price": {

"order": "desc"

}

}

]

}

分页查询

GET supplier/user/_search

{

"query": { "match_all": {} },

"from": 1,

"size": 1

}

指定要查询显示的field

GET supplier/user/_search

{

"query": { "match_all": {} },

"_source": ["name", "price"]

}

3、query filter

搜索name为‘lisi’并且price大于1500的

GET supplier/user/_search

{

"query" : {

"bool" : {

"must" : {

"match" : {

"name" : "lisi"

}

},

"filter" : {

"range" : {

"price" : { "gt" : 1500}

}

}

}

}

}

4、full-text search(全文检索)

address这个字段,会先被拆解,建立倒排索引

GET /ecommerce/product/_search

{

"query" : {

"match" : {

"address" : "bei jing"

}

}

}

5、phrase search(短语搜索)

跟全文检索相对应,相反,全文检索会将输入的搜索串拆解开来,去倒排索引里面去一一匹配,只要能匹配上任意一个拆解后的单词,就可以作为结果返回

phrase search,要求输入的搜索串,必须在指定的字段文本中,完全包含一模一样的,才可以算匹配,才能作为结果返回

GET /ecommerce/product/_search

{

"query" : {

"match_phrase" : {

"address" : "bei jing"

}

}

}

6、highlight search(高亮搜索结果)

GET /ecommerce/product/_search

{

"query" : {

"match" : {

"address" : "bei jing"

}

},

"highlight": {

"fields" : {

"address" : {}

}

}

}

原 文

关于Elasticsearch 6.2 / Kibana查询:必须存在一个字段而不得存在一个字段和查询必须至少包含一个目标字段的问题就给大家分享到这里,感谢你花时间阅读本站内容,更多关于Elasticsearch --- 01 java , elasticsearch, kibana 的下载安装,es初识、ElasticSearch 5 学习 (1)—— 安装 Elasticsearch、Kibana 和 X-Pack、Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana、elasticsearch kibana简单查询等相关知识的信息别忘了在本站进行查找喔。

本文标签:

![[转帖]Ubuntu 安装 Wine方法(ubuntu如何安装wine)](https://www.gvkun.com/zb_users/cache/thumbs/4c83df0e2303284d68480d1b1378581d-180-120-1.jpg)